Najwięksi gracze rynkowi oferują obecnie usługi dostępu do chatbotów opartych na dużych modelach językowych (LLM). Technologie te wykorzystują mechanizmy uczenia maszynowego oraz przetwarzania języka naturalnego (NLP), umożliwiając analizę danych wejściowych i generowanie trafnych odpowiedzi – w sposób zbliżony do naturalnej rozmowy międzyludzkiej. Aby zwiększyć swoją wydajność i kreatywność podjąłem decyzje o zakupie takiej usługi. Niestety po wstępnej analizie ofert doszedłem do wniosku, że sprawa nie jest prosta. Wręcz przeciwnie, bardzo złożona i wymaga głębokiej analizy ofert.

Wstępnie przyjąłem dwa podstawowe kryteria jakimi będę się kierował przy ocenie i ostatecznej decyzji.

1. Kryterium ochrony danych osobowych i informacji chronionych.

OpenAI – ChatGPT

Krótkie cytaty z dokumentów zamieszczonych na stronach firmy OpenAI.

„Jak wspomniano powyżej, możemy wykorzystywać Treści, które nam dostarczasz, aby ulepszać nasze Usługi, na przykład w celu trenowania modeli, które zasilają ChatGPT. Zapoznaj się z naszymi instrukcjami(opens in a new window), aby dowiedzieć się, w jaki sposób możesz zrezygnować z wykorzystywania przez nas Twoich Treści do trenowania naszych modeli.”

„Możemy ujawnić Twoje Dane osobowe w następujących okolicznościach:

– dostawcom i usługodawcom,

– jeśli jesteśmy zaangażowani w transakcje strategiczne, przeprowadzamy reorganizację i, ogłosiliśmy upadłość, ustanowiliśmy zarząd komisaryczny lub przenosimy usługi do innego dostawcy (łącznie „Transakcja”), Twoje Dane osobowe mogą zostać ujawnione w procesie badania due diligence kontrahentom i innym osobom pomagającym w Transakcji i przekazane następcy prawnemu lub podmiotowi powiązanemu w ramach tej Transakcji wraz z innymi aktywami.

– władzom państwowym i innym osobom trzecim,

– podmiotom powiązanym,

– administratorom kont biznesowych,

– innym użytkownikom i osobom trzecim,”

Jak wskazano powyżej, ChatGPT i nasze inne usługi są rozwijane z wykorzystaniem: (1) informacji, które są publicznie dostępne w Internecie, (2) informacji, do których mamy dostęp dzięki współpracy z osobami trzecimi, oraz (3) informacji, które dostarczają lub generują nasi użytkownicy, trenerzy i badacze.

Zgodnie z postanowieniami warunków korzystania z produktów i usług dostawcy („Service Terms”[2] i „Terms of Use”[3]), dostawca ma prawo do wykorzystywania treści przetwarzanych w ramach udostępnianych użytkownikowi narzędzi na potrzeby utrzymania, rozwijania i ulepszania swoich technologii. Mowa tu nie tylko o danych wejściowych („Input”, czyli np. wprowadzanych do ChatGPT przez użytkownika treści w celu ich podsumowania i skrócenia), ale również o danych wyjściowych („Output”, czyli uzyskanego rezultatu – w tym przypadku podsumowania i skrócenia tekstu).

Należy mieć na uwadze, że wszelkie wprowadzone do ChatGPT dane przekazywane są do wykorzystania i przetwarzania przez dostawcę, posiadającego swoją siedzibę w USA, a zakres tego przetwarzania nie jest precyzyjnie określony. Dodatkowo, na podstawie warunków korzystania, dostawca ChatGPT nie podejmuje wobec użytkownika konkretnych zobowiązań do zachowania poufności wprowadzanych informacji.

Oznacza to, że wykorzystywanie ChatGPT w celach biznesowych, polegających na analizie wprowadzonych, poufnych danych, może doprowadzić do ujawnienia informacji prawnie chronionych (w tym tajemnicy przedsiębiorstwa czy innych tajemnic regulowanych szczególnymi przepisami prawa, jak np. tajemnica lekarska czy bankowa) i naruszenia w ten sposób zobowiązań umownych czy przepisów prawa.

Nie ulega wątpliwości, że wykorzystanie omawianego rozwiązania przez polskich czy europejskich użytkowników w zakresie obejmującym przetwarzanie danych osobowych będzie wprost podlegało regulacjom RODO, a zatem powinno być dokonywane zgodnie z zasadami określonymi w przepisach. Co więcej, przy takim korzystaniu z ChatGPT potencjalnie może dochodzić do przekazania danych osobowych poza obszar EOG.

Zgodnie z warunkami używania produktów i usług OpenAI, w zakresie prawnie dozwolonym OpenAI przenosi na użytkownika wszelkie prawa do wszystkich treści wygenerowanych przy użyciu oferowanych narzędzi, zatem również wytworzonych przez ChatGPT („OpenAI hereby assigns to you all its right, title and interest in and to Output”). Dostawca zastrzega sobie przy tym prawo wykorzystywania tych treści w zakresie niezbędnym do świadczenia i utrzymania swoich usług, a także przestrzegania prawa i wewnętrznych regulacji („OpenAI may use Content as necessary to provide and maintain the Services, comply with applicable law, and enforce our policies”).

Dostawca ChatGPT stoi na stanowisku, zgodnie z którym prawa do generowanych treści w pierwszej kolejności przysługują właśnie jemu, a następnie przenosi on je w maksymalnym zakresie na użytkownika końcowego. Oczywiście w dalszym ciągu kwestia ta budzi poważne wątpliwości na gruncie powszechnie obowiązujących przepisów prawa, jak już wskazywaliśmy powyżej. W związku z czym do stanowiska dostawcy należy podchodzić z dużą ostrożnością.

Należy pamiętać, że nawet korzystne uregulowania zawarte w umowie z dostawcą ChatGPT nie będą stanowiły wystarczającej ochrony w przypadku uznania, że wygenerowane utwory naruszają prawa osób trzecich (np. twórców utworów, na których „uczył się” chat).

Microsoft 365 Copilot

Krótkie cytaty z dokumentów zamieszczonych na stronach firmy Microsoft.

Usługa Microsoft 365 Copilot jest zgodna z naszymi istniejącymi zobowiązaniami dotyczącymi ochrony prywatności, zabezpieczeń i zgodności z przepisami wobec klientów komercyjnych platformy Microsoft 365, w tym z Ogólnym rozporządzeniem o ochronie danych (RODO) i Geograficznym ograniczeniem przetwarzania danych z Unii Europejskiej (UE).

Polecenia, odpowiedzi i dane dostępne za pośrednictwem platformy Microsoft Graph nie są używane do trenowania dużych modeli językowych, w tym tych używanych przez usługę Microsoft 365 Copilot.

Microsoft 365 Copilot działa z wieloma zabezpieczeniami, które obejmują, ale nie są ograniczone do, blokowanie szkodliwych treści, wykrywanie chronionych materiałów i blokowanie szybkich zastrzyków (ataki jailbreak).

Microsoft 365 Copilot Może generować odpowiedzi zakotwiczone w danych organizacyjnych, takich jak dokumenty użytkownika, wiadomości e-mail, kalendarz, czaty, spotkania i kontakty. Rozwiązanie Microsoft 365 Copilot łączy tę zawartość z kontekstem roboczym użytkownika, takim jak spotkanie, w którym użytkownik teraz uczestniczy, wymiana wiadomości e-mail na dany temat lub konwersacja na czacie, którą użytkownik prowadził w zeszłym tygodniu. Usługa Microsoft 365 Copilot wykorzystuje to połączenie zawartości i kontekstu, aby pomóc w dostarczaniu dokładnych, odpowiednich i kontekstowych odpowiedzi.

Usługa Microsoft 365 Copilot wyświetla tylko te dane organizacyjne, do których poszczególni użytkownicy mają co najmniej uprawnienia do wyświetlania. Ważne jest, aby używać modeli uprawnień dostępnych w usługach platformy Microsoft 365, takich jak SharePoint, aby zapewnić odpowiednim użytkownikom lub grupom odpowiedni dostęp do odpowiedniej zawartości w organizacji. Obejmuje to uprawnienia udzielane użytkownikom spoza organizacji za pośrednictwem rozwiązań do współpracy między dzierżawami

Rozwiązanie Microsoft 365 Copilot używa usług Azure OpenAI do przetwarzania, a nie publicznie dostępnych usług OpenAI. Usługa Azure OpenAI nie buforuje zawartości klienta.

Jeśli używasz wtyczek w celu ułatwienia funkcji Microsoft 365 Copilot dostarczania bardziej odpowiednich informacji, sprawdź oświadczenie o ochronie prywatności i warunki korzystania z wtyczki, aby określić, jak będzie ona obsługiwać dane organizacji.

W sekcji Aplikacje zintegrowane Centrum administracyjnego Microsoft 365 administratorzy mogą wyświetlić uprawnienia i dostęp do danych wymagane przez wtyczkę, a także warunki użytkowania wtyczki i oświadczenie o ochronie prywatności. Administratorzy mają pełną kontrolę nad wyborem wtyczek dozwolonych w ich organizacji. Użytkownik może uzyskać dostęp tylko do wtyczek, na które zezwala jego administrator i które użytkownik zainstalował lub do których został przypisany. Funkcja Microsoft 365 Copilot używa tylko wtyczek, które są włączone przez użytkownika.

Gdy użytkownik wchodzi w interakcję z funkcją Microsoft 365 Copilot (korzystając z aplikacji takich jak Word, PowerPoint, Excel, OneNote, Loop lub Whiteboard), przechowujemy dane dotyczące tych interakcji. Przechowywane dane obejmują monit użytkownika i odpowiedź funkcji Copilot, w tym cytaty do wszelkich informacji używanych do ugruntowania odpowiedzi funkcji Copilot. Określamy monit użytkownika i odpowiedź copilot na ten monit jako „zawartość interakcji”, a zapis tych interakcji jest historią działania Copilot użytkownika. Na przykład te przechowywane dane udostępniają użytkownikom historię aktywności copilot w Microsoft 365 Copilot Chat (wcześniej o nazwie Czat biznesowy) i spotkania w usłudze Microsoft Teams. Te dane są przetwarzane i przechowywane zgodnie ze zobowiązaniami umownymi wraz z inną zawartością organizacji na platformie Microsoft 365. Dane są szyfrowane, gdy są przechowywane i nie są używane do trenowania podstawowych modułów LLM, a w tym tych używanych przez funkcję Microsoft 365 Copilot.

Użytkownicy mogą usunąć swoją historię aktywności Copilot, która obejmuje monity i odpowiedzi zwracane przez copilot.

Geograficzne ograniczenie przetwarzania danych z UE

Wywołania funkcji Copilot platformy Microsoft 365 do LLM są kierowane do najbliższych centrów danych w regionie, ale mogą również nawiązywać połączenia z innymi regionami, w których pojemność jest dostępna w okresach wysokiego wykorzystania.

W przypadku użytkowników z Unii Europejskiej oferujemy dodatkowe zabezpieczenia w celu zapewnienia zgodności z Geograficznym ograniczeniem przetwarzania danych z UE. Ruch w UE podlega Geograficznemu ograniczeniu przetwarzania danych z UE, podczas gdy ruch na całym świecie może być wysyłany do UE i innych lokalizacji geograficznych na potrzeby przetwarzania przez duże modele językowe.

Miejsce przechowywania danych

Funkcja Microsoft 365 Copilot przestrzega zobowiązań dotyczących miejsca przechowywania danych, jak określono w Warunkach dotyczących produktów firmy Microsoft i Uzupełnienia o Ochronie Danych. Funkcja Microsoft 365 Copilot została dodana jako obciążenie objęte zobowiązaniami do przechowywania danych w Warunkach dotyczących produktów firmy Microsoft 1 marca 2024 r.

Oferty Microsoft Advanced Data Residency (ADR) i Multi-Geo Capabilities obejmują zobowiązania do przechowywania danych dla klientów funkcji Microsoft 365 Copilot od 1 marca 2024 r. W przypadku klientów z UE funkcja Microsoft 365 Copilot jest usługą Geograficznego ograniczenia przetwarzania danych z UE. Zapytania klientów spoza UE mogą być przetwarzane w Stanach Zjednoczonych, UE lub innych regionach.

Wykrywanie materiałów chronionych i prawa autorskie

Tak, funkcja Microsoft 365 Copilot zapewnia wykrywanie chronionych materiałów, w tym tekstu objętego prawami autorskimi i kodem podlegającym ograniczeniom licencjonowania. Nie wszystkie te ograniczenia ryzyka są istotne dla wszystkich scenariuszy funkcji Microsoft 365 Copilot.

Firma Microsoft nie rości sobie praw własności do wyników usługi. Mimo to nie ustalamy, czy wyniki klienta są chronione prawami autorskimi lub czy można je wymusić względem innych użytkowników. Wynika to z faktu, że generatywne systemy sztucznej inteligencji mogą generować podobne odpowiedzi na podobne polecenia lub zapytania od wielu klientów. W związku z tym wielu klientów może mieć lub rościć sobie prawa do zawartości, która jest taka sama lub w znacznym stopniu podobna.

Odpowiedzialność Microsoft

Microsoft 365 Copilot – Odpowiedzi generowane przez generującą sztuczną inteligencję mogą nie być w 100% faktyczne. Mimo że stale ulepszamy odpowiedzi, użytkownicy nadal powinni kierować się własną oceną, przeglądając dane wyjściowe przed wysłaniem ich do innych osób.

Jeśli strona trzecia pozwie klienta komercyjnego o naruszenie praw autorskich za korzystanie z usług Copilot firmy Microsoft lub wygenerowane przez nie dane wyjściowe, będziemy bronić klienta i zapłacimy kwotę wszelkich niekorzystnych wyroków lub ugód wynikających z pozwu sądowego, o ile klient korzystał z zabezpieczeń i filtrów zawartości wbudowanych w nasze produkty.

2. Kryterium funkcjonalne

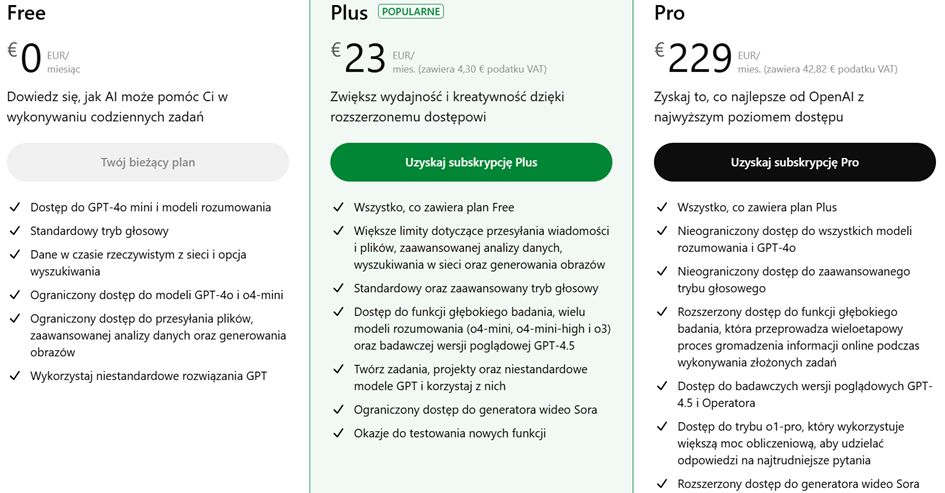

OpenAI – ChatGPT

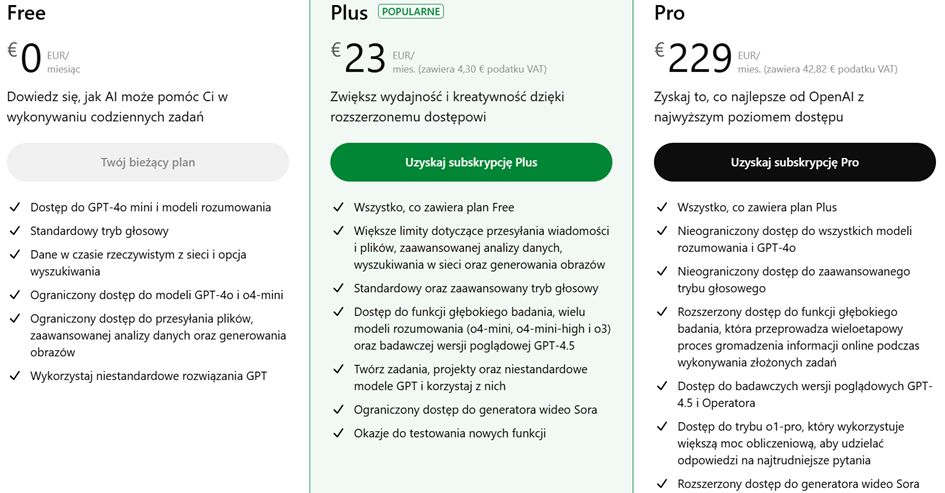

Plany osobiste

Rysunek 1(Źródło: OpenAI)

Plany biznesowe

Rysunek 2(Źródło: OpenAI)

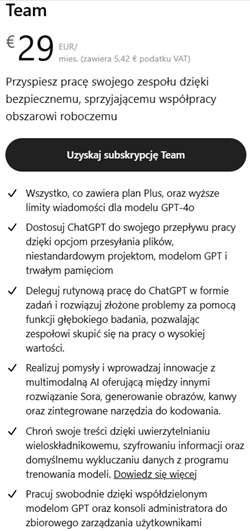

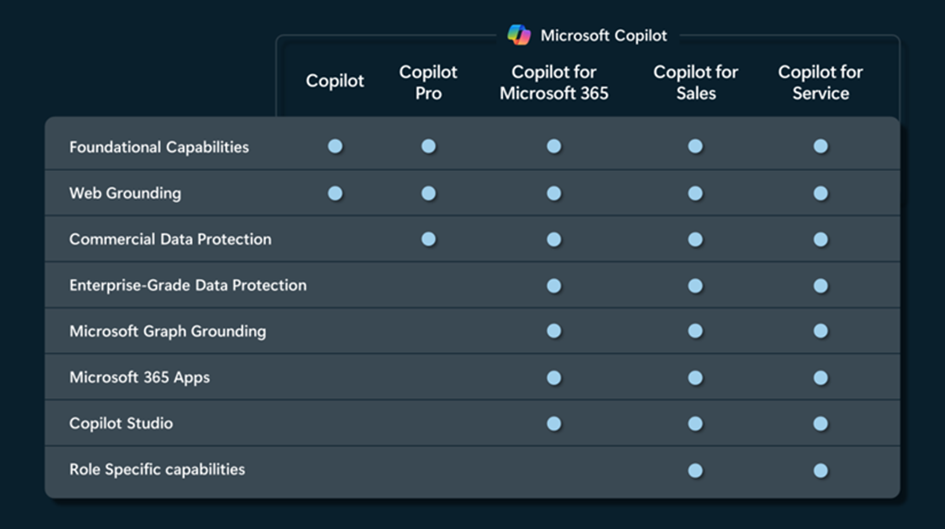

Poniżej tabela funkcji COPILOT w zależności od wersji.

Rysunek 3(Źródło: Microsoft)

Porównanie:

|

Cecha/Funkcja

|

Microsoft Copilot

|

Copilot Pro

|

Copilot Microsoft 365

|

|

Cena

|

Bezpłatny

|

98 złotych miesięcznie

|

30 dolarów miesięcznie

|

|

Dostępność

|

Online

|

Windows, macOS

|

Zintegrowany z Microsoft 365

|

|

Zaawansowane funkcje AI

|

Podstawowe

|

Rozszerzone limity na modelach AI, GPT-4 Turbo, Dall-E

|

Pełna integracja z Microsoft 365, automatyzacja zadań w Excel, PowerPoint, Teams i innymi

|

|

Bezpieczeństwo i prywatność

|

Podstawowe bezpieczeństwo danych, adekwatne dla użytkowników indywidualnych.

|

Ulepszone zabezpieczenia i większa prywatność danych niż w wersji bezpłatnej.

|

Najwyższe standardy bezpieczeństwa i prywatności z wersją komercyjną Microsoft 365, zapewniającą zaawansowaną ochronę danych i zgodność z przepisami. Idealne dla przedsiębiorstw wymagających kompleksowej ochrony danych.

|

|

Personalizacja

|

Ograniczona

|

Zaawansowana

|

Pełna personalizacja do środowiska organizacji

|

|

Zalecane

|

Użytkownicy, którzy chcą przetestować możliwości AI

|

Użytkownicy indywidualni poszukujący zaawansowanego wsparcia AI

|

NGO i firmy korzystające z Microsoft 365

|

|

Wymagania licencyjne

|

Brak (więcej funkcji po zalogowaniu)

|

Konto Microsoft (osobiste)

|

Microsoft 365 Business Standard, Microsoft 365 Business Premium, Microsoft 365 E3/E5, Office 365 E3/E5

|

|

Cena

|

bezpłatnie

|

20 USD / miesięcznie / licencja

|

ok. 24 USD / miesięcznie / licencja

|

(Źródło: techsoup.pl)

Z powyższego wynika, że Microsoft ma bogatszą ofertę pod względem funkcjonalności oraz oferuje szerszą ochronę informacji i danych osobowych. Dodatkowo deklaruje zgodność z RODO.

Nie doszukałem się informacji żeby OpenAi gwarantowało przetwarzanie danych w Unii Europejskiej (UE) i zgodność z RODO co dyskwalifikuje to narzędzie pod względem ochrony danych osobowych. A nigdy nie wiesz czy pracownik przypadkiem nie zamieści pełnej wersji pisma z adresem i nazwiskami adresatów do analizy.

W mojej ocenie wykorzystywanie bezpłatnych wersji AI w środowiskach biznesowych oraz w szeroko rozumianej administracji publicznej powinno zostać zakazane. Główne zagrożenie stanowi brak gwarancji ochrony przetwarzanych informacji, a także ryzyko ich wykorzystania do trenowania modeli językowych, co może prowadzić do nieuprawnionego ujawnienia danych wrażliwych lub strategicznych.

Źródła:

- https://openai.com/pl-PL/policies/row-privacy-policy/

- https://help.openai.com/en/articles/9299542-jak-rozwijany-jest-chatgpt-i-nasze-modele-podstawowe

- https://www.traple.pl/chatgpt-w-praktyce-najwazniejsze-kwestie-prawne/#_ftn2

- https://learn.microsoft.com/pl-pl/copilot/microsoft-365/microsoft-365-copilot-privacy

- https://www.microsoft.com/pl-pl/ai/principles-and-approach

- https://www.techsoup.pl/blog/porównanie-microsoft-copilot-copilot-pro-copilot-microsoft-365-–-który-wybrać